L’intelligence artificielle est sur le point de franchir un nouveau cap. Google DeepMind et Google Research viennent de dévoiler “Titans” en Décembre 2025, une nouvelle architecture de modèle conçue pour résoudre l’un des plus grands défis des LLM actuels : la mémoire.

Grâce à une innovation technique baptisée MIRAS, cette IA est désormais capable de se souvenir d’informations traitées il y a longtemps, surpassant les limites des Transformers classiques.

Le problème de la mémoire dans l’IA actuelle

Pour comprendre l’importance de Google Titans, il faut d’abord saisir le fonctionnement des modèles de langage actuels (comme GPT-4 ou Claude). Ces modèles, basés sur l’architecture “Transformer”, utilisent ce qu’on appelle une fenêtre de contexte.

Imaginez cette fenêtre comme la mémoire vive (RAM) de l’IA. Tant que l’information est dans cette fenêtre, l’IA “s’en souvient”. Mais dès que la conversation s’allonge ou que les documents deviennent trop volumineux, les informations les plus anciennes sont “oubliées”. Bien que les fenêtres de contexte s’agrandissent (128k, 1M de tokens), elles restent gourmandes en calcul et finissent toujours par atteindre une limite.

C’est ici qu’intervient la nouvelle approche de Google.

Google Titans : Une architecture hybride pour une mémoire infinie

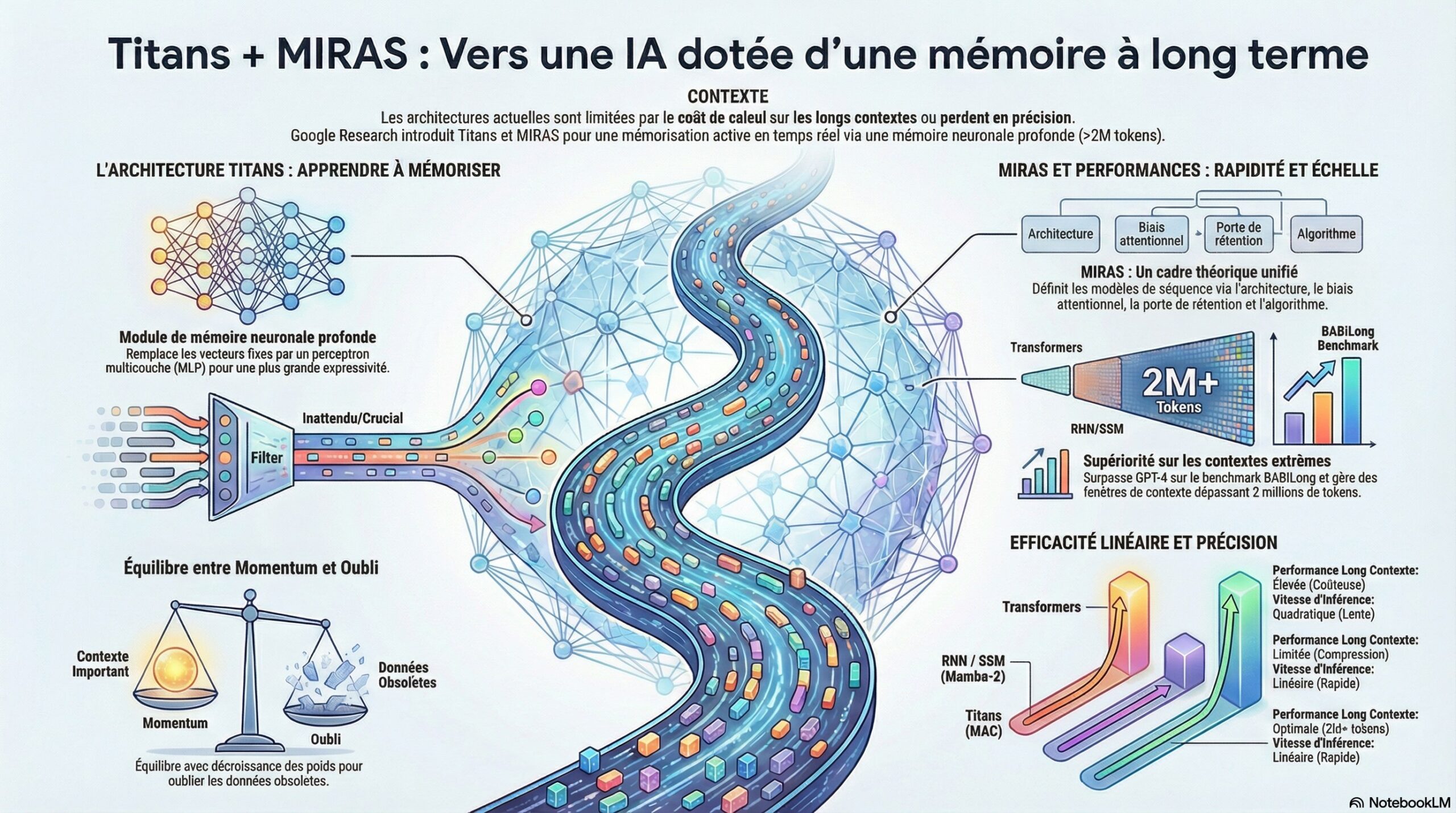

Google Titans n’est pas une simple mise à jour, c’est une architecture neuronale repensée. Contrairement aux Transformers qui doivent constamment “regarder” l’ensemble du contexte passé (mécanisme d’attention), Titans introduit le concept de mémoire neuronale à long terme.

L’idée est de combiner deux mécanismes :

- L’Attention (Court terme) : Pour gérer le contexte immédiat avec précision.

- La Mémoire Neuronale (Long terme) : Un module capable de stocker des abstractions du passé dans les poids du modèle, un peu comme notre cerveau stocke des souvenirs sans avoir besoin de se répéter la scène en boucle.

Cette capacité permet à l’IA de gérer des contextes dépassant les 2 millions de tokens avec une efficacité redoutable, là où les modèles classiques s’effondreraient sous la charge de calcul.

MIRAS : Le secret derrière la mémoire des Titans

Comment l’IA sait-elle quelle information “oubliée” doit être rappelée ? C’est le rôle de MIRAS.

L’acronyme signifie Memory as Context (La Mémoire comme Contexte). MIRAS est le mécanisme de déclenchement qui permet de connecter la mémoire à long terme au traitement actuel.

Comment fonctionne MIRAS ?

Contrairement aux architectures précédentes (comme les RNN ou les modèles d’état linéaire type Mamba) qui compressent tout le passé, MIRAS agit comme un gardien intelligent.

- L’IA reçoit une nouvelle requête.

- MIRAS génère une clé de requête basée sur cette entrée.

- Il interroge la mémoire neuronale profonde.

- Il récupère uniquement les informations pertinentes du passé et les injecte dans le mécanisme d’attention actuel.

En résumé, MIRAS permet à Google Titans de ne pas s’encombrer de tout l’historique, mais de “se souvenir” dynamiquement de ce qui est important au moment précis où il en a besoin.

Pourquoi Titans et MIRAS surpassent les Transformers ?

Les tests menés par Google Research montrent des résultats impressionnants. Sur des tâches complexes nécessitant de retrouver une information précise noyée dans des millions de mots (le fameux test “Needle in a Haystack”), Google Titans affiche des performances supérieures.

- Meilleure généralisation : L’IA apprend à gérer des séquences plus longues que celles vues lors de son entraînement.

- Efficacité : L’inférence (le temps de réponse) et l’entraînement sont plus rapides pour les très longs contextes comparés aux Transformers standards.

- Supériorité sur les alternatives : Titans surclasse les modèles linéaires récents (comme Mamba ou TTT) sur les tâches de mémorisation complexe.

Vers une IA plus humaine ?

Avec l’introduction de Google Titans et du mécanisme MIRAS, nous nous éloignons des modèles de langage qui ne sont que des “perroquets stochastiques” à mémoire courte.

Nous nous dirigeons vers une IA persistante, capable d’apprendre en temps réel et de conserver une “expérience” sur le très long terme.

Cette avancée promet de transformer les assistants personnels, l’analyse de données juridiques ou médicales, et la gestion de projets complexes, en offrant une mémoire quasi illimitée sans exploser les coûts de calcul.